Description

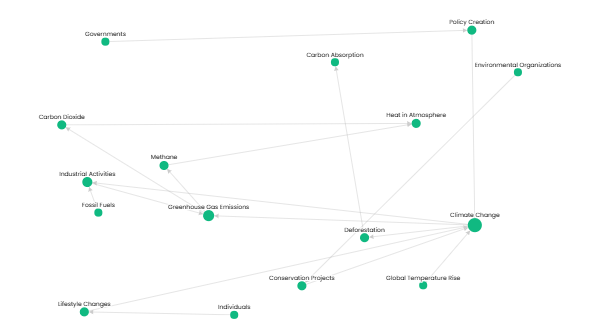

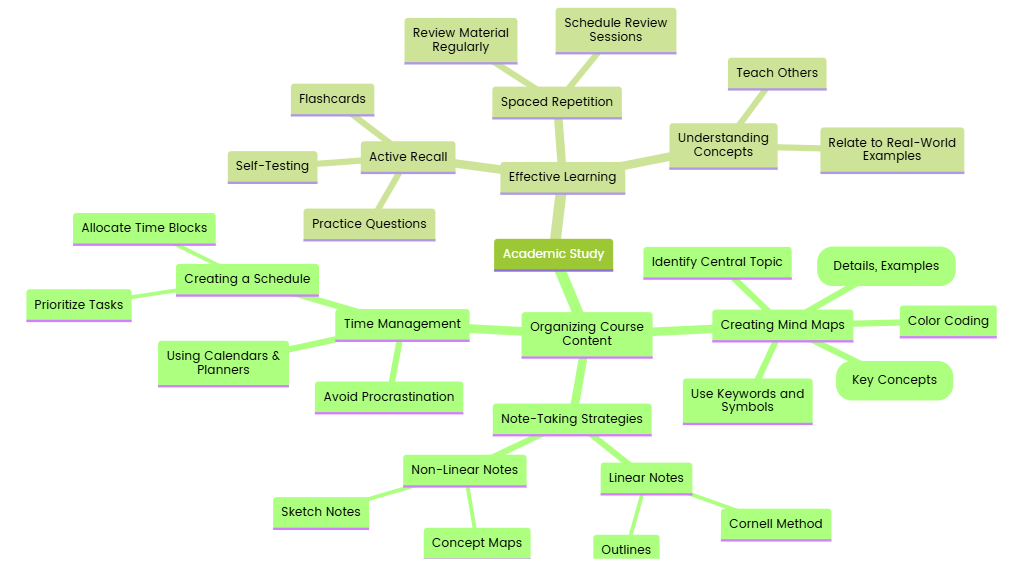

人工智能知识图谱是一种结构化的图形表示方法,用于描述人工智能领域各个知识点之间的层级、关联和语义关系。通过图谱的方式,可以更清晰地理解 AI 技术的全貌与发展路径,同时也能支持智能检索、语义理解和推理等应用。

该知识图谱的核心层次一般包括以下几个模块:

1. 基础概念层

- 人工智能(AI)

- 机器学习(Machine Learning)

- 深度学习(Deep Learning)

- 强人工智能(AGI)与弱人工智能(Narrow AI)

- 数据科学与统计学基础

2. 主要技术分支

- 监督学习

- 分类(Classification)

- 回归(Regression)

- 非监督学习

- 聚类(Clustering)

- 降维(Dimensionality Reduction)

- 强化学习

- Q-Learning

- 策略梯度

- 联邦学习、迁移学习、小样本学习

- 自监督学习、对比学习

3. 典型算法与模型

- 线性回归、逻辑回归

- 决策树、随机森林、XGBoost

- 支持向量机(SVM)

- K-means、PCA、t-SNE

- 神经网络(ANN)

- 卷积神经网络(CNN)

- 循环神经网络(RNN)

- Transformer

- BERT、GPT、Qwen、Claude 等大模型

4. 应用场景

- 自然语言处理(NLP)

- 文本生成、文本分类、命名实体识别、翻译、问答系统

- 计算机视觉(CV)

- 图像识别、目标检测、图像分割、OCR

- 语音处理

- 语音识别、语音合成、语义理解

- 多模态学习

- 图文、语音图像联合建模

- 推荐系统、搜索引擎、自动驾驶、金融风控、医疗辅助诊断等

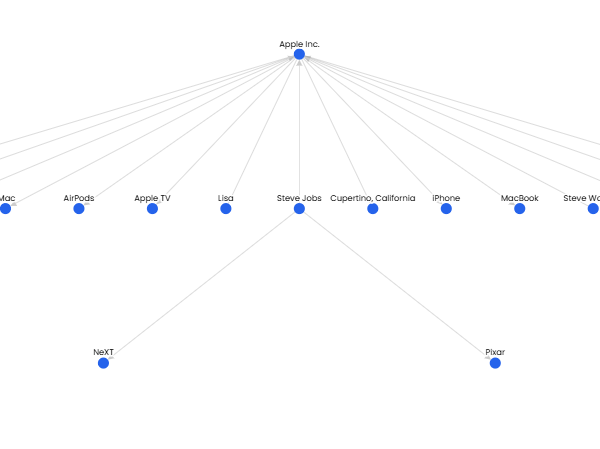

5. 工具与平台

- 编程语言与框架

- Python、TensorFlow、PyTorch、Scikit-learn

- 数据标注与增强

- 模型训练与部署平台

- Hugging Face、阿里云百炼、百度飞桨、AWS SageMaker 等

- 向量数据库与检索

- FAISS、Milvus、Weaviate、pgvector

6. 数据与伦理

- 数据集与标注标准

- 模型可解释性(Explainable AI)

- 算法公平性与偏见

- 数据隐私与安全

- 人工智能伦理和监管

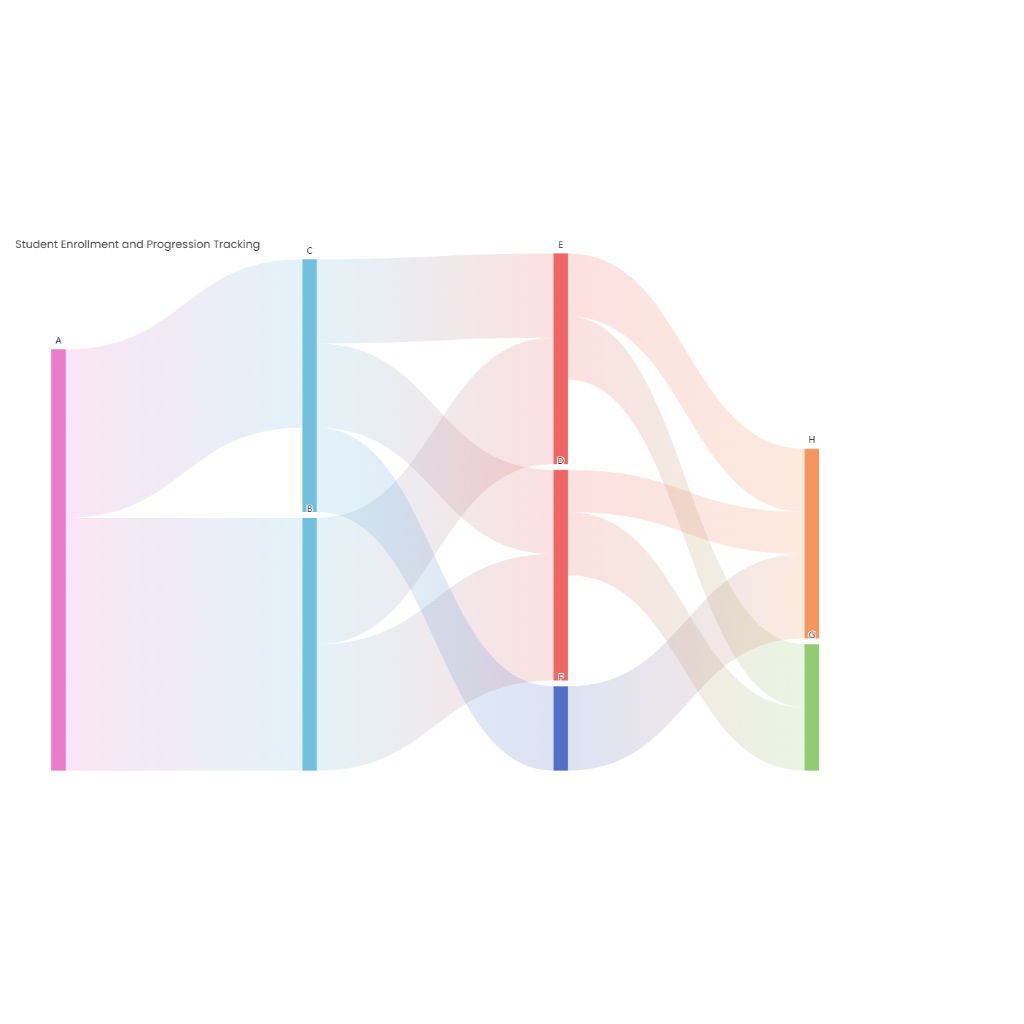

通过将上述知识点构建成图谱,可以以节点(概念)和边(关系)形式展示知识的全貌,如“Transformer 是 深度学习 的 一种架构”、“BERT 属于 NLP 预训练模型”等。这种图谱不仅适用于学习路径规划,也适用于构建智能化的问答系统、推荐系统以及企业内部的知识管理平台。